Joana Varon e Paz Peña

Notmy.ai é um esforço permanente, um debate sempre em curso que busca contribuir para o desenvolvimento de um quadro analítico feminista para questionar os sistemas algorítmicos de tomada de decisão que estão sendo implantados pelo setor público. Nosso objetivo final é o de desenvolver argumentos e construir pontes para promover a defesa de direitos junto a diferentes grupos de direitos humanos, desde defensores dos direitos das mulheres até grupos LGBTQI+, especialmente na América Latina, para responder à tendência estatal de adotar sistemas de I.A. para implantar políticas sociais, não apenas ignorando suas implicações sobre os direitos humanos, como também sem levar em conta relações de poder opressivas que podem ser reforçadas por um falso senso de neutralidade trazido pela automação. Automação do status quo, envolvendo desigualdades e discriminação.

O hype dos sistemas de I.A. promove uma narrativa recorrente de que processos automatizados de tomada de decisão podem fazer mágica para “resolver” problemas sociais, econômicos, ambientais e políticos, o que acaba levando a gastos de recursos públicos de formas questionáveis, permitindo que empresas privadas já monopolistas explorem com fins lucrativos e sem restrições os dados pessoais sensíveis dos cidadãos. Esses sistemas tendem a ser desenvolvidos por estratos da população privilegiados, contra o livre arbítrio e sem ouvir a opinião nem ter a participação desde o início daqueles que provavelmente serão alvos ou “ajudados”, resultando em opressão e discriminação automatizadas perpetradas pelos Digital Welfare States [Estados do Bem-Estar Digital, em tradução livre], que recorrem à matemática como desculpa para se esquivar de qualquer responsabilidade política. Em última análise, essa tendência tem o poder de descartar qualquer tentativa de uma resposta coletiva, democrática e transparente aos principais desafios da sociedade.

Para enfrentar essa tendência tão difundida, partimos da perspectiva de que as abordagens feministas descoloniais da vida e das tecnologias são ótimos instrumentos para imaginar futuros alternativos e para derrubar a lógica prevalecente segundo a qual os sistemas de I.A. são implantados. Como Silvia Rivera Cusicanqui afirma: “Como o ‘nós’ exclusivo e etnocêntrico pode ser articulado com o ‘nós’ inclusivo – uma pátria para todos – que prevê a descolonização? Como pensamos e problematizamos, no aqui e no agora, o presente colonizado e sua superação?” (tradução livre).

Se seguirmos Cusicanqui, é fácil entender que respostas como “otimização de algoritmos tendenciosos”, I.A. “ética”, “inclusiva”, “transparente” ou “centrada no ser humano”, “em conformidade com a legislação de proteção de dados” ou até mesmo uma abordagem de direitos humanos para sistemas de I.A. fracassam na missão política mais ampla de desmantelar o que a acadêmica feminista negra Patricia Hill Collins chama de matriz de dominação. Simplesmente adicionar uma camada de automação a um sistema falho significa aumentar a opressão disfarçadamente, fantasiada de uma falsa sensação de neutralidade matemática.

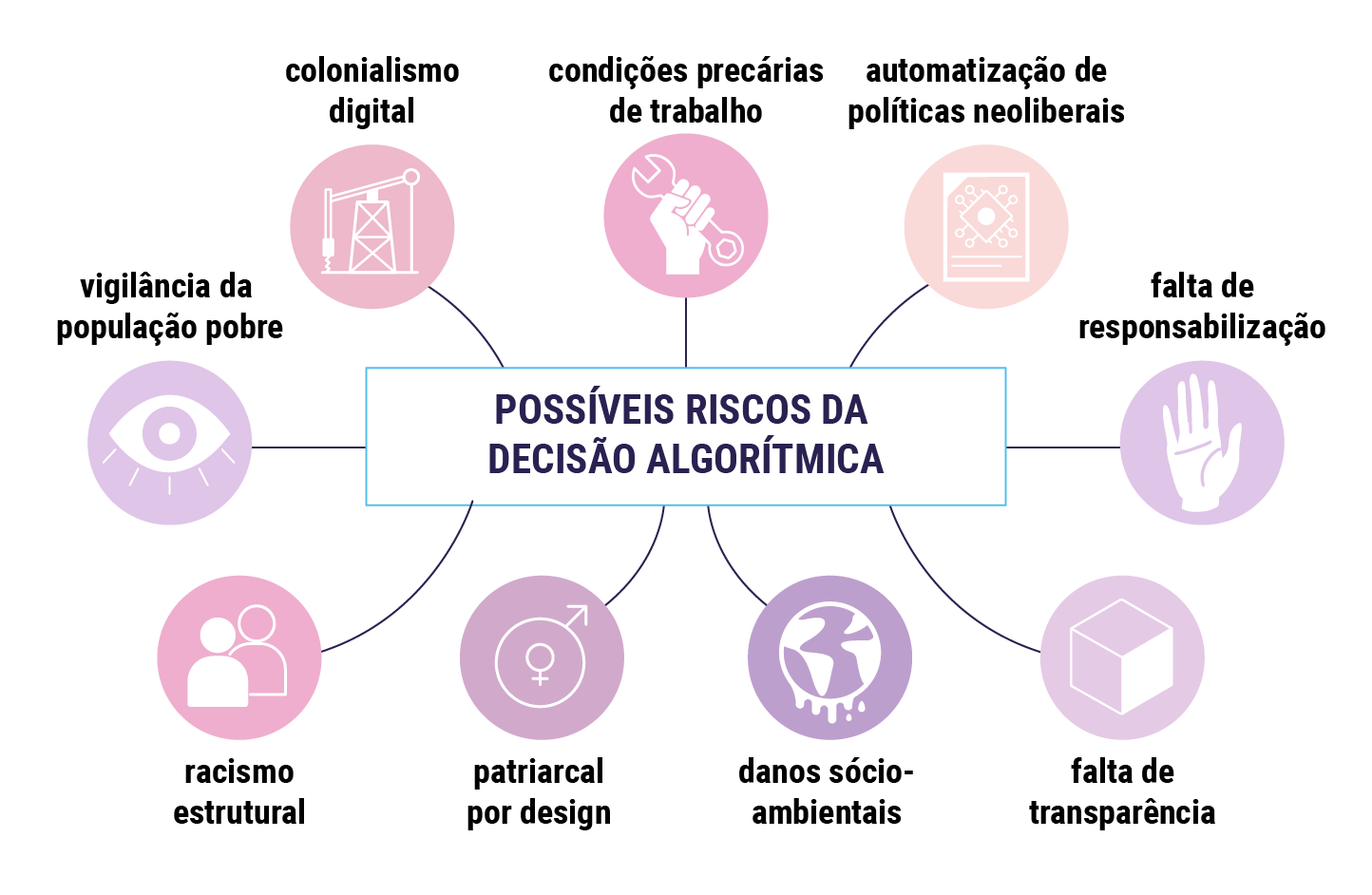

O debate atual sobre princípios e estruturas de I.A. foca-se principalmente em “como os consertar?”, em vez de “por que realmente precisamos deles?” e “em benefício de quem”. Portanto, a primeira ferramenta do nosso kit de ferramentas para questionar sistemas de I.A. é o método da I.A. Opressora, que elaboramos com base na análise empírica de casos da América Latina e na revisão bibliográfica da literatura crítica. Um determinado sistema de I.A. baseia-se na vigilância dos pobres? Ele está automatizando políticas neoliberais? Baseia-se no trabalho precário e no extrativismo colonial de corpos de dados e recursos de nossos territórios? Quem o desenvolve faz parte do grupo-alvo ou é provável que ele reafirme desigualdades estruturais de raça, gênero e sexo? O público em geral consegue dispor de transparência suficiente para verificar por si mesmo a exatidão das respostas às perguntas anteriores? Essas podem ser algumas das questões a serem consideradas.

Diversas políticas nacionais para I.A. e a maioria das startups e grandes empresas de tecnologia operam segundo o lema “mova-se rápido e quebre as coisas”, ou seja, inovar primeiro e verificar depois os possíveis danos causados. Propomos o contrário: antes de se desenvolver ou implantar uma I.A., ela deve ser analisada quanto à probabilidade de que automatize a opressão. Além disso, se esse sistema de A.I não está focado em expor os poderosos, nem tem como alvo seus próprios desenvolvedores ou seu grupo identitário, então os desenvolvedores também não são as pessoas certas para verificar se tal sistema se enquadra nas categorias de I.A. Opressora. E essas categorias não são fixas, podendo se expandir de acordo com o contexto específico, como por exemplo: se um sistema de I.A. é desenvolvido para o acesso aos serviços públicos, mas favorece unicamente a capacidade das pessoas, então ele pode ser considerado uma I.A. Opressora, pois está excluindo pessoas com deficiência do acesso a serviços públicos. Portanto, fique atento, a proposta de quadro analítico da I.A. Opressora não está escrito em pedra, é apenas um guia geral para formular perguntas, um trabalho em curso e deve ser remodelada de acordo com o contexto específico e suas opressões. Nesse sentido, fazemos referência aos Design Justice Network Principles [Princípios da Rede de Justiça do Design, em tradução livre] como uma diretriz importante para avaliar o contexto de opressão, uma vez que ela “coloca no centro as pessoas que são normalmente marginalizadas pelo design e usa práticas colaborativas e criativas para enfrentar os desafios enfrentados por uma comunidade específica” (tradução livre).

Além disso, não custa fazer uma verificação contextualizada da I.A. Opressora, por que não perguntar: este pode ser um sistema de I.A. transfeminista? O que significa desenvolver um algoritmo feminista?

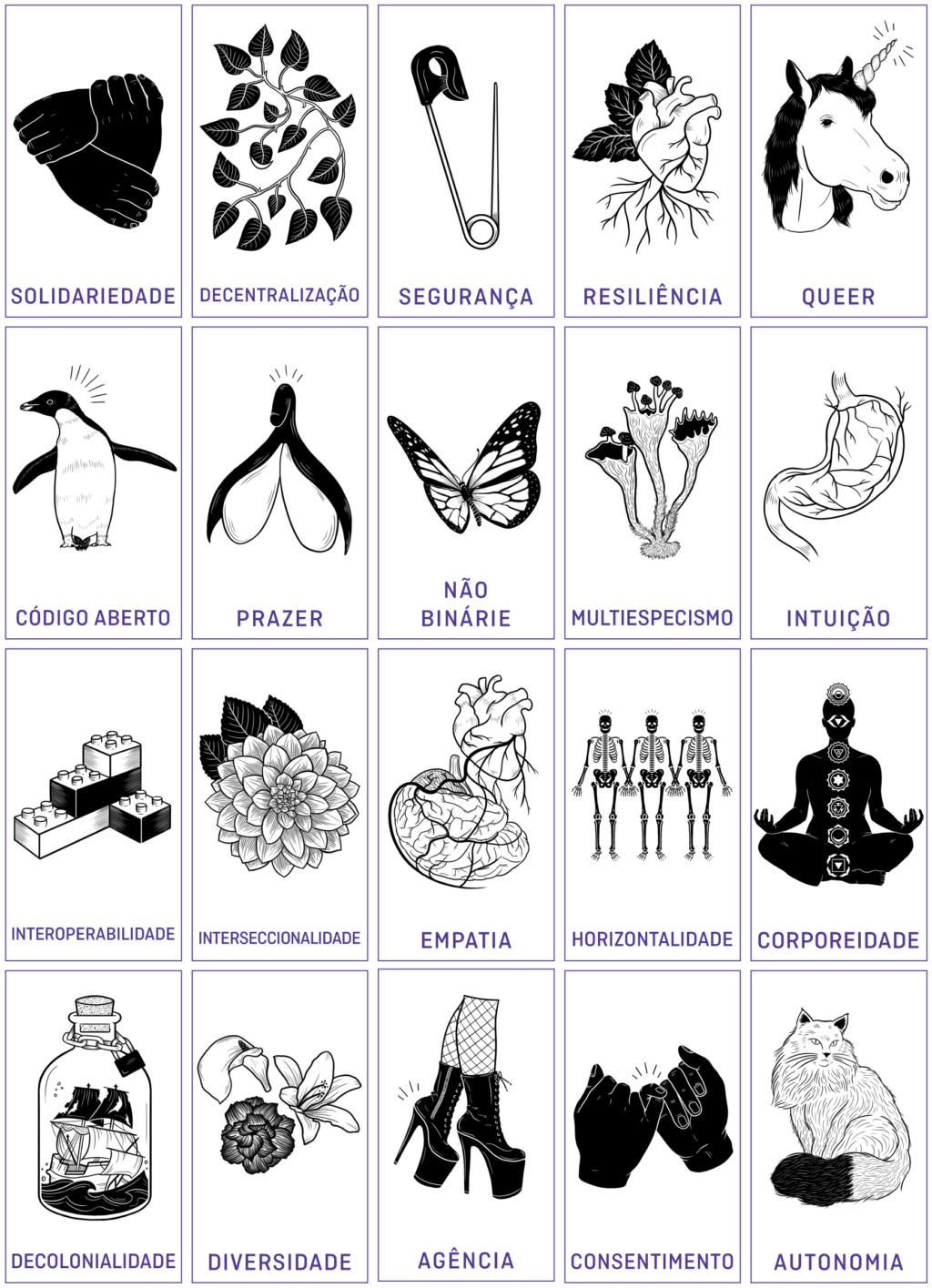

Acreditamos que os valores transfeministas podem ser incorporados aos sistemas de I.A., assim como os valores atuais como lucro, vício, consumismo e racismo estão embutidos em vários algoritmos pertinentes às nossas vidas de hoje. Para colocar essa abordagem feminista em prática, nós da Coding Rights, em parceria com nossa querida e brilhante acadêmica e ativista de design Sasha Costanza-Chock, temos testado um jogo de cartas desenvolvido de forma colaborativa para projetar ferramentas em futuros especulativos: o “Oracle for transfeminist Technologies” [Oráculo para Tecnologias transfeministas, em tradução livre]. Ao longo de uma série de oficinas, temos feito um brainstorming coletivo sobre que tipo de valores transfeministas devem inspirar e nos ajudar a imaginar futuros especulativos. Como Ursula Le Guin disse certa vez: “o que acontece com a ficção científica é que não se trata realmente do futuro. É sobre o presente. Mas o futuro nos dá grande liberdade de imaginação. É como um espelho. Você pode ver a parte de trás da sua própria cabeça.”

De fato, propostas de mudanças presentes e tangíveis surgiram enquanto imaginávamos o futuro nas oficinas. Com o tempo, valores como agência, responsabilização, autonomia, justiça social, não binarismo, cooperação, descentralização, consentimento, diversidade, descolonialidade, empatia, segurança, entre outros, surgiram nas reuniões.

Embora tenha sido vislumbrado como um jogo, acreditamos que o conjunto de valores transfeministas discutidos em uma série de oficinas com feministas de diferentes regiões e diferentes pautas feministas identitárias também pode ser transformado em um conjunto de princípios orientadores para a concepção de projetos de I.A. transfeministas, práticas ou tecnologias alternativas que sejam mais condizentes com o presente e o futuro que queremos ver.

Isso é o que queremos fazer a seguir. Começamos com o artigo “Consent to our Data Bodies: Lessons from feminist theories to enforce data protection” [Consentimento para nossos Corpos de Dados: Lições das Teorias Feministas para Aplicar a Proteção de Dados, em tradução livre]. O que é uma abordagem feminista para o consentimento? Como isso pode ser aplicado às tecnologias? Perguntas simples como essas permitiram lançar luz sobre quão limitada é a noção individualista de consentimento proposta em regulamentos de proteção de dados. Universalizada, ela não leva em consideração as relações desequilibradas de poder. Ocorre que, se não temos a capacidade de dizer não às grandes empresas de tecnologia quando precisamos acessar um serviço monopolista, claramente não podemos consentir livremente. Estabelecer uma análise ampla desses valores, como fizemos com a noção de consentimento, pode aos poucos transformar o jogo em mais uma ferramenta analítica. Esse é um dos próximos passos que vamos dar 🙂 No momento, estamos fazendo um brainstorming de outros passos possíveis para ampliar o alcance e as ferramentas deste kit de ferramentas. Algumas atividades incluem continuar a testar sua aplicabilidade por meio de oficinas, estabelecer parcerias locais para aumentar a análise baseada em casos, estudar de modo permanente a nova bibliografia com abordagens críticas aos sistemas de I.A., e buscar apoio para traduções para o espanhol e o português. Além disso, caso você conheça outros projetos de I.A. sendo implantados na América Latina pelo setor público com possíveis implicações para o progresso das pautas feministas, nosso mapeamento é colaborativo e você pode enviá-los aqui. Se você tiver comentários sobre esses quadros analíticos, pode entrar em contato conosco pelo e-mail co*****@**********ts.org.