Paz Peña y Joana Varon

Estudio de caso: Plataforma Tecnológica de Intervención Social*/Proyecto Horus – Argentina y Brasil

Supongamos que se tiene acceso a una base de datos con información de 12.000 mujeres de entre 10 y 19 años, habitantes de alguna provincia pobre de Sudamérica. Los datos incluyen la edad, el barrio, la etnia, el país de origen, el nivel educativo del cabeza de familia, las discapacidades físicas y mentales, el número de personas que comparten la vivienda y la presencia o no de agua caliente en sus servicios. ¿Qué conclusiones se extraerían de una base de datos así? O, tal vez, la pregunta debería ser: ¿Es siquiera deseable tener alguna conclusión? A veces, y lamentablemente con más frecuencia que nunca, la mera posibilidad de extraer ingentes cantidades de datos es excusa suficiente para «hacerlos hablar» y, lo que es peor, tomar decisiones en función de ello. La base de datos descrita anteriormente es real. Y es utilizada por las autoridades públicas, inicialmente en el municipio de Salta, Argentina, de forma piloto desde 2015, bajo el nombre de «Plataforma Tecnológica de Intervención Social». En teoría, el objetivo del sistema era prevenir la deserción escolar y el embarazo adolescente.

¿Quién lo desarrolla?

El proyecto comenzó como una asociación con el Ministerio de la Primera Infancia de la Provincia de Salta, Argentina, y Microsoft. El sistema es presentado por un representante de ambos como una herramienta predictiva muy precisa, casi mágica: «Los algoritmos inteligentes permiten identificar características en las personas que pueden terminar en alguno de estos problemas y avisar al gobierno para trabajar en su prevención», dijo el representante de Microsoft Azure, el sistema de machine learning del programa. «Con la tecnología, a partir del nombre, el apellido y el domicilio, se puede predecir con cinco o seis años de anticipación qué chica, futura adolescente, está predestinada en un 86% a tener un embarazo adolescente», declaró Juan Manuel Urtubey, político conservador y gobernador de Salta para el momento del despliegue del piloto.

Auditorías del sistema y otras críticas

Pero predecir e incluso predestinar a alguien para el embarazo no es tan sencillo, ni para las personas matemáticas, ni para las adivinas. No en vano, empezaron a surgir críticas sobre la «Plataforma Tecnológica de Intervención Social». Algunos calificaron el sistema como una mentira, una inteligencia que no piensa, una alucinación y un riesgo para los datos sensibles de mujeres y niños pobres. Un análisis técnico muy completo sobre sus fallas fue publicado por el Laboratorio de Inteligencia Artificial Aplicada (LIAA) de la Universidad de Buenos Aires. Según el LIAA, que analizó la metodología publicada en GitHub por el ingeniero de Microsoft, los resultados fueron falsamente sobredimensionados debido a errores estadísticos en la metodología, la base de datos está sesgada, no tiene en cuenta las sensibilidades de la denuncia de embarazos no deseados y, por lo tanto, los datos recogidos son inadecuados para hacer cualquier predicción futura y es probable que incluya embarazos de un determinado sector de la sociedad antes que otros, estigmatizando a los pobres. Según Luciana Ferrer, investigadora de LIAA:

«Si se asume que quienes respondieron las encuestas dijeron la verdad sobre su embarazo antes o en el momento de la encuesta, es probable que nuestros datos sean inexactos. En un tema tan delicado como el embarazo adolescente, sería prudente suponer que muchas adolescentes no se sienten seguras para decir la verdad, sobre todo si tienen o quieren abortar (en Argentina, al igual que en varios países de América Latina, el acceso al aborto seguro sólo estaba legalizado en casos de violación o cuando la salud de la madre estaba en riesgo. La situación en el país cambió recién en diciembre de 2020, cuando se aprobó un histórico proyecto de ley que legaliza la libertad de elección para interrumpir el embarazo hasta la semana 14). Esto implica que, al utilizar estos datos, estaremos aprendiendo de una información sesgada, influenciada por el hecho de que en algunos sectores privilegiados de la población había acceso al aborto seguro y, en otros, el tema es un tabú, por lo tanto, es algo que la adolescente ocultaría en una entrevista».

Es interesante destacar que el Ministerio de la Primera Infancia trabajó durante años con la ONG antiabortista, Fundación CONIN, para mostrar este sistema. La declaración de Urtubey anteriormente mencionada se realizó en medio de la campaña para cambiar la ley hacia la legalización del aborto en Argentina, una demanda social que en 2018 copó las noticias locales e internacionales durante meses. La idea de que los algoritmos pueden predecir el embarazo adolescente antes de que ocurra fue la excusa perfecta para que los activistas anti-mujeres y anti-derechos sexuales y reproductivos declararan innecesarias las leyes de aborto seguro. Según sus narrativas, si tienen suficiente información de las familias pobres, se pueden desplegar políticas públicas conservadoras para predecir y evitar los abortos de las mujeres pobres. Además, también era común, pero errónea, la creencia que, si lo recomienda un algoritmo, es matemático, por lo que debe ser cierto e irrefutable.

Además, también es destacable que el sistema haya optado por trabajar sobre una base de datos compuesta únicamente por datos femeninos. Este enfoque específico en un sexo concreto también refuerza los roles de género patriarcales y, en última instancia, culpa a las adolescentes de los embarazos no deseados, como si un niño pudiera ser concebido sin un espermatozoide. Peor aún, también puede verse como una iniciativa que se aleja de una lógica de culpabilización de la víctima, sobre todo si tenemos en cuenta que la base de datos incluye a niñas de 10 años y a menores un poco mayores, cuyo embarazo sólo sería resultado de la violencia sexual. ¿Cómo puede una máquina decir que es probable que sea víctima de una agresión sexual? ¿Y cómo es de brutal concebir tal cálculo?

Pero, incluso frente a varias críticas, la iniciativa siguió desplegándose. Y lo que es peor, las malas ideas vestidas de innovación se extienden rápidamente: el sistema se está desplegando en otras provincias argentinas, como La Rioja, Chaco y Tierra del Fuego. También se ha exportado a Colombia, implementado al menos en el municipio de La Guajira y, como veremos, a Brasil.

De Argentina a Brasil

Otra iteración de ese mismo proyecto también ha llegado al Gobierno Federal de Brasil, a través de una asociación con el Ministerio de Ciudadanía de Brasil y Microsoft. Supuestamente, en septiembre de 2019, Brasil fue el 5º país de América Latina en contar con el Projeto Horus, presentado en los medios de comunicación como una «solución tecnológica para monitorear programas sociales enfocados en el desarrollo infantil.» La primera ciudad en probar el programa fue Campina Grande, del Estado de Paraíba, en la región nordeste de Brasil, una de las más pobres del país. Entre las autoridades e instituciones que asistieron a la reunión de arranque se encontraba un representante de Microsoft, el Ministerio de la Primera Infancia del municipio de Salta y miembros del Ministerio de Ciudadanía de Brasil. Romero Rodrigues, el alcalde de Campina Grande, también está alineado con las iglesias evangélicas.

Análisis

A través de solicitudes de acceso a la información (anexo I), hemos consultado a la Secretaría Nacional de Atención a la Primera Infancia (SNAPI) y a la Subsecretaría de Tecnologías de la Información (STI) de ese Ministerio para requerir más información sobre la asociación. Estas instituciones informaron que:

«El Ministerio de la Ciudadanía ha firmado con Microsoft Brasil LTDA el acuerdo de cooperación técnica n° 47/2019, para una prueba de concepto de una herramienta de inteligencia artificial para subvencionar mejoras en las acciones del programa (Criança Feliz/Primeira Infância)”.

El Ministerio de la Ciudadanía de Brasil, que firmó el acuerdo, es Osmar Gasparini Terra que, aunque no lo crean, es un simpatizante del terraplanismo, es decir, una teoría que no cree que la Tierra tenga un formato esférico. Al igual que el negacionismo del cambio climático y el creacionismo, algunos alegaron que la teoría de la Tierra plana tiene su base en el fundamentalismo cristiano. Terra también tuvo un discurso negacionista sobre la pandemia del COVID-19, pero, en ese caso, creyó en las matemáticas y en la Inteligencia Artificial como única herramienta para producir diagnósticos que informen las políticas públicas, como se expresa en el acuerdo:

«El Ministerio desea realizar un análisis para el programa Criança Feliz, utilizando herramientas tecnológicas de procesamiento de datos basadas en inteligencia artificial como mecanismo de diagnóstico orientado a detectar situaciones de vulnerabilidad social como guía para la formulación de políticas públicas preventivas y transformadoras».

Al igual que en los casos chileno y argentino, una visión neoliberal estuvo detrás de la justificación de creer en un algoritmo para «automatizar, predecir, identificar, vigilar, detectar, focalizar y castigar a los pobres”. Algo que también quedó explícito en el acuerdo cuando señala que el propósito del sistema era «optimizar los recursos y la construcción de iniciativas que puedan mejorar la oferta de servicios dirigidos a la primera infancia, de forma más personalizada y con mayor efectividad».

Por lo tanto, se afirma una vez más la lógica de la automatización de las políticas neoliberales. Más concretamente, establecer un mecanismo para un Estado de Bienestar Digital, fuertemente dependiente de la recogida de datos y de las conclusiones que de ellos surjan:

«La cooperación tiene como objetivo construir, de forma conjunta, una solución que recoja datos a través de formularios electrónicos y el uso de herramientas analíticas y de inteligencia artificial sobre estos datos para subvencionar acciones del programa Niño Feliz.»

Al ser preguntados por las bases de datos utilizadas, enumeraron:

- Sistema Único de Asistencia Social – SUAS (Sistema Único de Assistência Social)

- Registro Único (Cadastro Único)

- CADSUAS, del Ministerio de Desarrollo Social

Todas ellas son bases de datos de programas sociales en Brasil, en este caso, utilizadas bajo la lógica de la vigilancia de las comunidades vulnerables, que no sólo son pobres, sino también de las y los niños. Todo eso en una asociación con una empresa extranjera. ¿Microsoft tenía acceso a todas esas bases de datos? ¿Cuál fue el intercambio para que la empresa entrara en el acuerdo, ya que no se acordó ninguna transferencia de recursos financieros?

«Este acuerdo no implicará la transferencia de recursos financieros entre las partes. Cada parte asumirá sus propios costes como resultado de los recursos asignados en la ejecución del alcance y sus atribuciones, sin obligación previa de asumir obligaciones basadas en sus resultados».

¿Tenía Microsoft acceso a la base de datos de las y los brasileños? ¿Está utilizando Microsoft la base de datos de los pobres de América Latina para entrenar sus sistemas de aprendizaje automático? Intentamos programar una entrevista con un representante de Microsoft en Brasil que hablaba del proyecto en los medios de comunicación, pero después de que enviamos las preguntas, la entrevista programada previamente fue cancelada. Estas fueron las preguntas enviadas a Microsoft:

- Considerando el convenio de cooperación técnica firmado en septiembre de 2019 entre el Ministerio de Ciudadanía y Microsoft para realizar una prueba de concepto para implementar herramientas de inteligencia artificial que apoyen las mejoras en las acciones del programa Niño Feliz:

- ¿Cuál es el resultado de la prueba de concepto?

- ¿Qué conjuntos de datos utilizó el algoritmo para detectar situaciones de vulnerabilidad social?

- ¿Qué tipo de acciones sugeriría la plataforma en caso de detección de vulnerabilidad y riesgo?

- ¿Cuáles son los siguientes pasos en esta prueba de concepto?

- ¿Tiene la empresa otros contactos con el Ministerio de Ciudadanía u otros ministerios del gobierno brasileño para pruebas de concepto o implementación de proyectos de inteligencia artificial para temas sociales?

- ¿Tiene la empresa una política interna para promover la investigación y el desarrollo de actividades de IA y el sector público centrado en el país?

Como no pudimos tener una posición de Microsoft, también pedimos al Ministerio más información sobre la prometida «mayor efectividad», que, sin embargo, nunca se demostró. Cuando se firmó el convenio, allá por septiembre de 2019, ya se publicaron muchas críticas analizando el caso de Salta, aunque el acuerdo sólo reconocía a Microsoft «la experiencia y la inteligencia adquirida». Como se ve a continuación:

«Mientras que Microsoft ya ha desarrollado un proyecto similar (…) con la PROVINCIA DE SALTA, en la República Argentina, y toda la experiencia e inteligencia obtenida de ella puede ser utilizada, con este acuerdo, se establece una cooperación para el desarrollo, adaptación y uso de una plataforma en Brasil».

Así que solicitamos información al ministro sobre los márgenes de error y datos sobre el resultado de la prueba de concepto. Nos informaron: «no hay información sobre el margen de error utilizado en las tecnologías implicadas”.

También afirmaron que el convenio tenía una duración de seis meses, a partir del 23 de septiembre de 2019. Por lo tanto, el acuerdo ya no estaba vigente al momento de la respuesta (18 de diciembre de 2020), por lo que reafirmaron: «destacamos que dicha tecnología no está siendo implementada por el Programa Niño Feliz, por lo tanto, no podemos atender la solicitud de datos estadísticos sobre su uso y efectividad».

Fue una afirmación extraña, teniendo en cuenta que, en el plan de trabajo adjunto al acuerdo, tanto Microsoft como el Ministerio tenían asignadas las actividades de análisis y evaluación de resultados. Pero en estas circunstancias y respuestas, podríamos decir que el intento de transponer el sistema a Brasil fue una expresión más del extractivismo colonial una vez que, supuestamente, ni siquiera el gobierno brasileño guardó registros de los resultados de la prueba de concepto, una caja cerrada. Lo único que sabemos es que, según el acuerdo, Microsoft se eximía de cualquier responsabilidad de posibles daños causados por el proyecto:

«Microsoft no garantiza ni asume responsabilidad alguna por las pérdidas y daños de cualquier tipo que puedan surgir, por ejemplo (I) la adecuación de las actividades previstas en el presente Acuerdo y los fines del Ministerio o para la entrega de cualquier solución efectiva; (II) la calidad, legalidad, fiabilidad y utilidad de los servicios, información, datos, archivos, productos y cualquier tipo de material utilizado por las otras partes o por terceros”.

Conclusiones

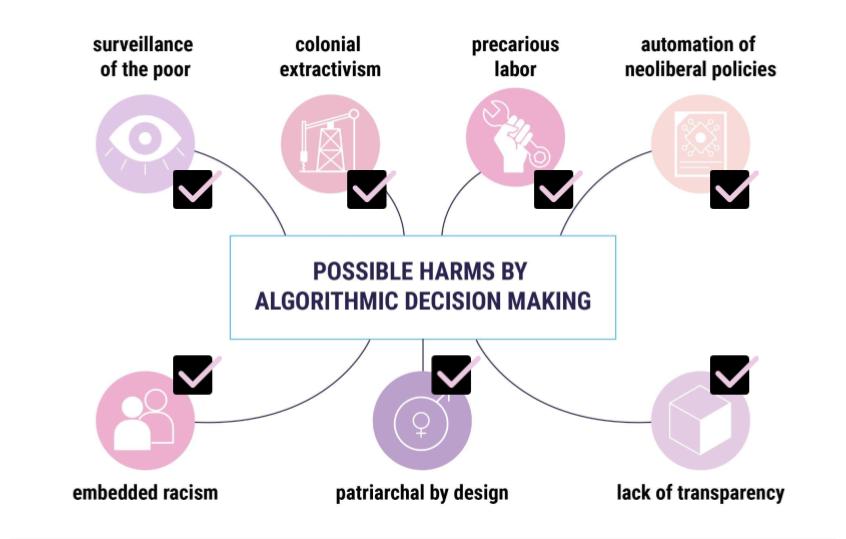

Los sistemas de Inteligencia Artificial examinados en los estudios de caso muestran que su diseño y uso por parte de los Estados responde a un continuo de políticas neoliberales que han abundado en América Latina, en mayor o menor medida, durante los últimos 40 años (López, 2020). Por un lado, son instrumentos que automatizan y otorgan el grado de resoluciones tecnológicas a las decisiones ideológicas: focalización de recursos (Alston, 2019). En este caso, se trata principalmente de utilizar el big data para producir una categoría más detallada de las y los niños y adolescentes pobres (López, 2020) y, un paso más allá, automatizar su determinación de riesgo social. El enfoque de infancia vulnerable es una clásica toma neoliberal, impuesta por entidades como el Banco Mundial en la región, y proviene de la idea de la pobreza como un problema individual (no sistémico) y de los asistentes sociales como protectores de las personas «en riesgo» (Muñoz Arce, 2018).

Por otro lado, estos sistemas de Inteligencia Artificial son un nuevo estado en la tecnocratización de las políticas públicas. Los grados de participación en su diseño y la transparencia del proceso es dudosa: en el caso de Brasil, el acuerdo de prueba de concepto tenía un plan de trabajo de seis meses, lo que hace evidente que no hubo intención de concebir un proceso inclusivo más amplio con la comunidad objetivo, sólo desplegar una herramienta tecnológica. Así, no sólo las y los ciudadanos brasileños no tienen acceso a ningún dato que evalúe la prueba piloto, sino que las personas afectadas por estos sistemas, es decir, las y los niños pobres, adolescentes y sus familias, ni siquiera son objeto de consulta, ya que no se les reconoce como partes interesadas. Asimismo, el consentimiento para utilizar sus datos presentados para obtener o no prestaciones sociales abre toda una discusión sobre la ética de estos sistemas que no ha sido resuelta.

Asimismo, hay evidencias de que el uso de la Inteligencia Artificial para predecir posibles vulnerabilidades no sólo no funciona bien en la atención social de las y los niños y adolescentes (Clayton et al., 2020), sino que, además, acaba siendo bastante costoso para los Estados, al menos en las primeras etapas, lo que parece ser contrario a la doctrina neoliberal (Bright et al. 2019). ¿Cuántas horas de recursos humanos de funcionarios públicos se desplegaron para una prueba de concepto cuyos resultados no están documentados y disponibles públicamente?

Aunque existe la noción de las tecnologías como un sistema sociotécnico, prevalece la concepción de la IA como un proceso objetivo, tanto en la recolección como en el procesamiento de datos. Esto es preocupante en varios sentidos. Primero, porque los Estados y los desarrolladores prestan poca atención al sesgo de clase social y de raza, repitiendo la idea racial del daltonismo (Noble, 2018; Benjamin, 2019). En segundo lugar, se espera que los errores de la tecnología en la predicción del riesgo entre las y los niños y adolescentes estén blindados por la intervención humana, dando a la máquina cierta impunidad para seguir trabajando. Sin embargo, no hay estudios de campo en el caso que hemos examinado que consideren cómo los trabajadores sociales que interactúan con la máquina lidian o no con el «sesgo de automatización» referido a la mayor valorización de la información automatizada que nuestras propias experiencias (Bridle, 2018).

En resumen, podemos decir que La «Plataforma Tecnológica de Intervención Social» y el Projeto Horus son solo un ejemplo muy elocuente de cómo la pretendida neutralidad de la Inteligencia Artificial se ha desplegado cada vez más en algunos países de América Latina para ayudar a políticas públicas potencialmente discriminatorias que podrían socavar los derechos humanos de las personas no privilegiadas, así como vigilar y censurar a las mujeres y sus derechos sexuales y reproductivos. Analizando nuestro marco de la Inteligencia Artificial Opresiva podríamos decir que cumple todos los requisitos:

Enlaces de solicitudes de transparencia y respuestas del gobierno brasileño

- Pedido&resposta_LAI_MinCidadania_71003_129432_2020_71

- Acordo_Cooperacao_Tecnica_47__Microsoft

- Pedido&resposta_LAI_MinCidadania_71003_129428_2020_11

- Pedido&resposta_LAI_MinEcon_00106_030439_2020_31

- Pedido&resposta_LAI_MMFDH_00105_003197_2020_12

* El extracto del componente argentino de este estudio de caso fue desarrollado y publicado originalmente en el artículo «Descolonizar la IA: una crítica feminista hacia los datos y la justicia social», escrito por los mismos autores de este informe para la publicación Giswatch: Inteligencia Artificial Derechos Humanos 2019, disponible en: https://www.giswatch.org/node/6203

Bibliografía

Alston, Philip. 2019. Report of the Special rapporteur on extreme poverty and human rights. Promotion and protection of human rights: Human rights questions, including alternative approaches for improving the effective enjoyment of human rights and fundamental freedoms. A/74/48037. Seventy-fourth session. Item 72(b) of the provisional agenda.

Benjamin, R. (2019). Race after technology: Abolitionist tools for the new Jim code. Polity.

Birhane, Abeba (2019, July 18th). The Algorithmic Colonization of Africa. Real Life Magazine. www.reallifemag.com/the-algorithmic-colonization-of-africa/

Bridle, J. (2018). New Dark Age: Technology, Knowledge and the End of the Future. Verso Books.

Bright, J., Bharath, G., Seidelin, C., & Vogl, T. M. (2019). Data Science for Local Government (April 11, 2019). Available at SSRN: https://ssrn.com/abstract=3370217 or http://dx.doi.org/10.2139/ssrn.3370217

Clayton, V., Sanders, M., Schoenwald, E., Surkis, L. & Gibbons, D. (2020) MACHINE LEARNING IN

CHILDREN’S SERVICES SUMMARY REPORT. What Works For Children’s Social Care. UK.

Crawford, Kate. (2016, June 25th). Artificial Intelligence’s White Guy Problem. The New York Times. www.nytimes.com/2016/06/26/opinion/sunday/artificial-intelligences-white-guy-problem.htm

Daly, Angela et al. (2019). Artificial Intelligence Governance and Ethics: Global Perspectives. THE CHINESE UNIVERSITY OF HONG KONG FACULTY OF LAW. Research Paper No. 2019-15.

Davancens, Facundo.Predicción de Embarazo Adolescente con Machine Learning: https://github.com/facundod/case-studies/blob/master/Prediccion%20de%20Embarazo%20Adolescente%20con%20Machine%20Learning.md

Eubanks, V. (2018). Automating inequality: how high-tech tools profile, police, and punish the poor. First edition. New York, NY: St. Martin’s Press.

Kidd, Michael (2016). Technology and nature: a defence and critique of Marcuse. Volum IV, Nr. 4 (14), Serie nouă. 49-55. www.revistapolis.ro/technology-and-nature-a-defence-and-critique-of-marcuse/

Laboratorio de Inteligencia Artificial Aplicada. 2018. Sobre la predicción automática de embarazos adolescentes. www.dropbox.com/s/r7w4hln3p5xum3v/[LIAA]%20Sobre%20la%20predicci%C3%B3n%20autom%C3%A1tica%20de%20embarazos%20adolescentes.pdf?dl=0 y https://liaa.dc.uba.ar/es/sobre-la-prediccion-automatica-de-embarazos-adolescentes/

López, J. (2020). Experimentando con la pobreza: el SISBÉN y los proyectos de analítica de datos en Colombia. Fundación Karisma. Colombia.

Masiero, Silvia & Das, Soumyo (2019). Datafying anti-poverty programmes: implications for data justice. Information, Communication & Society, 22:7, 916-933.

Muñoz Arce , G. (2018): The neoliberal turn in Chilean social work: frontline struggles against

individualism and fragmentation, European Journal of Social Work, DOI:

10.1080/13691457.2018.1529657

Noble, S. U. (2018). Algorithms of oppression: How search engines reinforce racism. New York University Press.

O’Neal, Cathy. (2016). Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. New York: Crown.