Joana Varon and Paz Peña

Por Joana Varon y Paz Peña

NotMy.AI es un esfuerzo continuo y un debate en curso que busca contribuir al desarrollo de un marco feminista para cuestionar los sistemas algorítmicos de toma de decisiones que se están desplegando en el sector público. Nuestro objetivo final es desarrollar argumentos y construir puentes de incidencia con diferentes grupos de derechos humanos, desde defensores de los derechos de las mujeres hasta grupos LGBTIQ +, especialmente en América Latina, para hacer frente a la tendencia en la que los gobiernos están adoptando sistemas de Inteligencia Artificial para desplegar políticas sociales, no sólo sin considerar las implicaciones de los derechos humanos, sino también en el desprecio de las relaciones de poder opresivas que podrían ser amplificadas a través de un falso sentido de neutralidad traído por la automatización. La automatización del statu quo, sostenida por las desigualdades y la discriminación.

Los sistemas de Inteligencia Artificial de moda fomentan una narrativa recurrente según la cual los procesos automatizados de toma de decisiones pueden funcionar como una varita mágica para «resolver» los problemas sociales, económicos, medioambientales y políticos, lo que lleva a gastar recursos públicos de forma cuestionable, permitiendo a las empresas privadas, ya monopolistas, explotar datos sensibles de los ciudadanos con fines de lucro y sin restricciones. Estos sistemas tienden a ser desarrollados por demografías privilegiadas, en contra del libre albedrío y sin la opinión o participación desde cero de aquellos que son susceptibles de ser dirigidos, o «ayudados», resultando en una opresión y discriminación automatizada de los Estados de Bienestar Digitales que utilizan las matemáticas como excusa para saltarse cualquier responsabilidad política. En última instancia, esta tendencia tiene el poder de descartar cualquier intento de respuesta colectiva, democrática y transparente a los principales retos de la sociedad.

Para hacer frente a esta tendencia generalizada, partimos de la perspectiva de que los enfoques feministas decoloniales sobre la vida y las tecnologías son grandes instrumentos para vislumbrar futuros alternativos y para derrocar la lógica imperante en la que se están desplegando los sistemas de Inteligencia Artificial. Como plantea Silvia Rivera Cusicanqui (2012), «¿cómo articular el «nosotros» excluyente y etnocéntrico con el «nosotros» incluyente -una patria para todos- que vislumbra la descolonización? ¿Cómo hemos pensado y problematizado, en el aquí y ahora, el presente colonizado y su derrocamiento?» Si seguimos a Cusicanqui, es fácil comprender que respuestas como «optimización de algoritmos sesgados», I.A. «ética», «inclusiva», «transparente» o «centrada en el ser humano», «conforme a la legislación de protección de datos» o incluso únicamente un enfoque de derechos humanos para los sistemas de I.A. se quedan cortas en una misión política más amplia para desmantelar lo que la académica feminista negra Patricia Hill Collins llama la matriz de dominación. El mero hecho de añadir una capa de automatización a un sistema fallido supone magnificar de forma oculta la opresión disfrazada de una falsa sensación de neutralidad matemática.

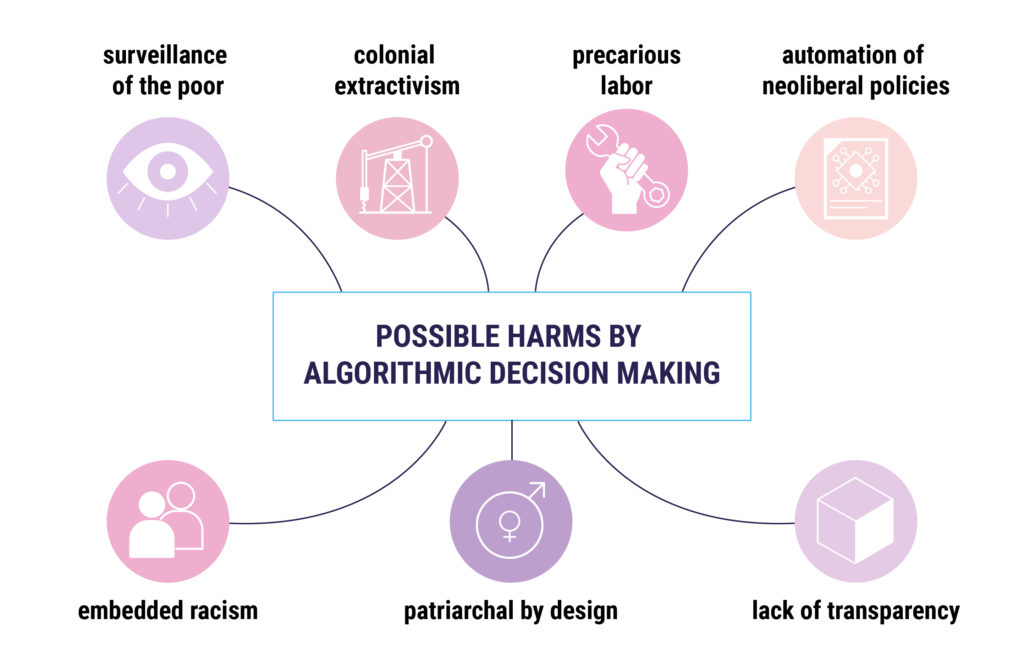

El debate actual sobre los principios y marcos de la Inteligencia Artificial se centra sobre todo en «¿cómo arreglarlo?», en lugar de «¿por qué lo necesitamos realmente?» y «¿en beneficio de quién?». Por lo tanto, la primera herramienta de nuestra caja de herramientas para cuestionar los sistemas de I.A. es el esquema de I.A. opresiva que redactamos basándonos tanto en el análisis empírico de casos de América Latina como en la revisión bibliográfica de la literatura crítica. ¿Un determinado sistema de I.A. se basa en la vigilancia de los pobres? ¿Automatiza las políticas neoliberales? ¿Se basa en la precariedad laboral y en el extractivismo colonial de cuerpos de datos y recursos de nuestros territorios? ¿Quién lo desarrolla forma parte del grupo al que va dirigido o es probable que reafirme las desigualdades estructurales de raza, género, sexualidad? ¿Puede la comunidad en general tener suficiente transparencia para comprobar por sí misma la exactitud de las respuestas a las preguntas anteriores? Podrían ser algunas de las preguntas para tener en cuenta.

Varias políticas nacionales de Inteligencia Artificial y la mayoría de las start-ups y grandes corporaciones tecnológicas operan bajo el lema de «muévete rápido y rompe cosas», es decir, innova primero y comprueba los posibles daños después. Nosotras proponemos lo contrario: antes de desarrollar o desplegar, hay que comprobar si esa Inteligencia Artificial es susceptible a automatizar la opresión. Además, si ese sistema de I.A. no se centra en denunciar a los poderosos, ni se dirige a sus propios desarrolladores o a su grupo de identidad, los desarrolladores tampoco son los que deben comprobar si ese sistema entra en las categorías de una I.A. opresora. Y esas categorías no son fijas, pueden ampliarse en función de un contexto concreto, por ejemplo: si se desarrolla un sistema de I.A. para acceder a los servicios públicos, pero sólo favorece el capacitismo, también puede considerarse una I.A. opresora, ya que está excluyendo a las personas con discapacidad del acceso a los servicios públicos. Así que, cuidado, el marco de la I.A. Opresiva propuesto no está escrito en piedra, es sólo una guía general de preguntas, un trabajo en proceso y deberá ser remodelado según el contexto particular y sus opresiones. En este sentido, recordamos los Principios de la Red de Justicia en el Diseño como una guía importante para evaluar el contexto de opresión, ya que «centra el diseño en las personas que normalmente están marginadas y utiliza prácticas colaborativas y creativas para abordar los retos a los que se enfrenta una comunidad concreta».

Además, más allá de una comprobación contextualizada de la I.A. opresora, [PP1] por qué no preguntar: ¿puede ser ésta una I.A. transfeminista? ¿Qué significa dibujar un algoritmo feminista?

Creemos que los valores transfeministas pueden incorporarse a los sistemas de Inteligencia Artificial, del mismo modo que actualmente valores como el lucro, la adicción, el consumismo o el racismo están incorporados a varios algoritmos que forman parte de nuestras vidas hoy en día. Para llevar a la práctica este enfoque feminista, en Coding Rights, en colaboración con nuestra querida y brillante académica y activista del diseño Sasha Costanza-Chock, hemos estado experimentando con un juego de cartas desarrollado en colaboración para diseñar herramientas en futuros especulativos: el «Oráculo para las tecnologías transfeministas«. A través de una serie de talleres, hemos hecho una lluvia de ideas colectiva sobre qué tipo de valores transfeministas deben inspirar y ayudarnos a imaginar futuros especulativos. Como dijo una vez Ursula Le Guin «lo que pasa con la ciencia ficción es que no trata realmente del futuro. Trata del presente. Pero el futuro nos da una gran libertad de imaginación. Es como un espejo. Puedes ver la parte de atrás de tu propia cabeza».

En efecto, una vez que imaginamos el futuro en los talleres, surgieron propuestas de cambio tangibles en el presente. Con el tiempo, valores como la agencia, la responsabilidad, la autonomía, la justicia social, lo no binario, la cooperación, la descentralización, el consentimiento, la diversidad, la decolonialidad, la empatía, la seguridad, entre otros, han surgido en las reuniones.

Algunas fichas del Oráculo para las Tecnologías Transfeministas, disponibles en transfeministech.org

Si bien se ha concebido como un juego, creemos que el conjunto de valores transfeministas que se han ido desgranando a lo largo de una serie de talleres con feministas de diferentes regiones y agendas feministas identitarias puede transformarse también en un conjunto de principios rectores para imaginar proyectos de I.A. transfeminista, tecnología alternativa o prácticas más coherentes con el presente y el futuro que queremos ver.

Eso es lo que queremos hacer a continuación. Hemos empezado con el artículo «El consentimiento de nuestros cuerpos de datos: Lecciones de las teorías feministas para aplicar la protección de datos», ¿Qué es un enfoque feminista del consentimiento? ¿Cómo puede aplicarse a las tecnologías? Esas sencillas preguntas pudieron arrojar luz sobre lo limitada que es la noción individualista del consentimiento propuesta en los marcos de protección de datos. Universalizada, no tiene en cuenta las relaciones de poder desiguales. Pero, si no tenemos la capacidad de decir no a las grandes empresas tecnológicas cuando necesitamos acceder a un servicio monopolístico, está claro que no podemos consentir libremente. Si se hace un análisis exhaustivo de estos valores, como hicimos con la noción de consentimiento, se puede convertir el juego en otra herramienta de análisis. Ese es uno de los pasos que estamos dando a continuación 🙂

Actualmente estamos pensando en otros posibles pasos para ampliar tanto el alcance como las herramientas de este juego de herramientas. Algunas actividades implican seguir probando su aplicabilidad a través de talleres, desarrollar asociaciones locales para aumentar el análisis basado en casos, estudiar continuamente nueva bibliografía con enfoques críticos de los sistemas de Inteligencia Artificial, y buscar apoyo para traducciones al español y al portugués. Además, si conoces otros proyectos de I.A. que se estén desplegando en América Latina por el sector público con posibles implicaciones para el avance de las agendas feministas, nuestro mapeo es colaborativo y puedes presentarlos aquí. Si tienes comentarios sobre estos marcos, puedes contactarnos en co*****@**********ts.org.